Sitemap

A list of all the posts and pages found on the site. For you robots out there is an XML version available for digesting as well.

Pages

Posts

F-learning方法论文阅读笔记

Published:

大型语言模型 (LLM) 的最新进展展示了其在文本理解和生成方面的卓越能力。然而,即使是更强大的 LLM 也容易从训练语料库中获取错误或过时的信息。直接使用包含新知识的数据进行二次微调可能会因新旧知识之间的冲突而无法有效更新知识。在本文中,我们提出了一种新的微调范式,称为 F-Learning(Forgetting before Learning),它使用参数算法来促进旧知识的遗忘和新知识的学习。在两个公开数据集上的实验结果表明,我们提出的 F-Learning 可以明显提高完全微调和 LoRA 微调的知识更新性能,在大多数情况下同时超越现有基线。此外,我们还发现通过减去 LoRA 的参数来忘记旧知识可以产生与减去完全微调的参数类似的效果,有时甚至会大大超过它。

latent adversarial unlearning方法论文阅读笔记

Published:

虽然LLM在许多领域取得了成功,但仍然受到训练语料库中问题内容的困扰。LLM 反学习旨在减少它们的影响并避免不良行为。然而,现有的反学习方法仍然容易受到对抗性查询的攻击,并且反学习的知识会在手动设计的攻击查询之后重新出现。作为红队主动评估反学习模型漏洞的一部分,本文设计了动态反学习攻击 (DUA),这是一个动态的自动化框架来攻击这些模型并评估其鲁棒性。它优化了对抗性后缀以在各种场景中重新引入未学习的知识。本文发现,即使不透露反学习模型的参数,55.2% 的问题也可以重现反学习的知识。为了解决这一弱点,本文提出了潜在对抗性反学习 (LAU),这是一个通用框架,可以有效增强反学习过程的鲁棒性。它将反学习过程公式化为最小-最大优化问题,并通过两个阶段解决:攻击阶段,训练扰动向量并将其添加到 LLM 的潜在空间以恢复反学习的知识;防御阶段,使用先前训练的扰动向量来增强反学习模型的鲁棒性。借助LAU框架,本文获得了两种鲁棒的反学习方法:AdvGA 和 AdvNPO。本文在多个反学习基准和各种模型上进行了广泛的实验,并证明它们将反学习效果提高了 53.5% 以上,仅导致邻近知识减少不到 11.6%,并且几乎不影响模型的一般能力。

DEPN方法论文阅读笔记

Published:

在大量数据上进行预训练的大型语言模型可以捕获训练数据中的丰富知识和信息。先前的研究揭示了预训练语言模型中数据记忆和反省的能力,这带来了数据泄露的风险。为了有效降低这些风险,本文提出了一个框架DEPN来检测和编辑预训练语言模型中的隐私神经元,部分灵感来自知识神经元和模型编辑。在DEPN中,本文引入了一种新方法,称为隐私神经元检测器,用于定位与隐私信息相关的神经元,然后通过将其激活设置为零来编辑这些检测到的隐私神经元。此外,本文提出了一种隐私神经元聚合器,以批处理方式取消记忆隐私信息。实验结果表明,DEPN可以显着有效地减少隐私数据泄露的风险,而不会降低模型的性能。此外,本文从多个角度(包括模型大小、训练时间、提示、隐私神经元分布)实证证明了模型记忆与隐私神经元之间的关系,说明了本文方法的鲁棒性。

PCGU论文阅读笔记

Published:

最近的研究表明,大规模预训练语言模型往往会表现出与种族主义、性别歧视、宗教偏见和一般毒性有关的问题。不幸的是,这些预训练语言模型几乎普遍用于下游任务,而自然语言处理通常用于进行现实世界的预测。因此,在开发过程中尽早消除这些语言模型的偏见对于防止自然语言系统造成的无意伤害越来越重要。为此,我们提出了一种称为分区对比梯度反学习 (PCGU) 的新技术,这是一种用于消除预训练掩码语言模型偏见的灰盒方法。PCGU 旨在仅优化对特定偏见领域贡献最大的权重,通过基于对比句子对的梯度计算一阶近似来实现。我们的实验表明,PCGU 既成本低廉,又似乎特别有效地查明大型预训练 Transformer 中隐性社会偏见的来源。虽然我们仅在性别职业领域使用 PCGU 进行训练,但我们发现这样做也可以部分减轻其他领域的偏见。

Quark论文阅读笔记

Published:

大规模语言模型通常会学习与用户期望不一致的行为。生成的文本可能包含攻击性或有害语言,包含大量重复内容,或者与用户期望的情绪不同。本文考虑通过微调语言模型来消除这些不一致,以了解哪些行为不该做。本文引入了量化奖励调节 (Quark),这是一种优化奖励函数的算法,该函数量化 (不) 想要的属性,同时不会偏离原始模型太远。Quark 交替进行以下操作:(i) 使用当前语言模型收集样本,(ii) 根据奖励将它们按奖励分位数分类,每个分位数由奖励标记标识,并附加到语言模型的输入前面,以及 (iii) 对每个分位数的样本使用标准语言建模损失,这些样本以其奖励标记为条件,同时通过 KL 散度惩罚保持在原始语言模型附近。通过在生成时以高奖励标记为条件,该模型生成的文本表现出较少的不想要的属性。实验表明,对于消除毒性、负面情绪和重复,Quark 的表现优于强基线和最先进的强化学习方法,如 PPO,同时仅依赖于标准语言建模原语。

Mechanistic Unlearning-Robust Knowledge Unlearning and Editing via Mechanistic Localization论文阅读笔记

Published:

大型语言模型中的知识编辑和反学习方法寻求编辑或删除不需要的知识或能力,而不会损害一般语言建模性能。本文研究了机械可解释性(部分旨在识别与构成模型能力的特定可解释机制相关的模型组件(电路))如何提高编辑和反学习的精度和有效性。 本文发现在训练通过不同方法定位的组件时,反学习和编辑稳健性存在明显差异。本文强调了主要基于保留输出来定位组件的方法与寻找具有可预测中间状态的高级机制的方法之间的重要区别。特别是,将编辑/遗忘定位到与事实回忆查找表机制相关的组件 1) 会导致跨不同输入/输出格式的更稳健的编辑/遗忘,并且 2) 抵制重新学习不需要的信息的尝试,同时与基线相比减少了意外的副作用,在体育事实数据集和多个模型的 CounterFact数据集上都是如此。某些局部编辑比任何其他基线都更能破坏模型中的潜在知识,从而使反学习对各种攻击更具鲁棒性。

An Adversarial Perspective on Machine Unlearning for AI Safety论文阅读笔记

Published:

大型语言模型经过微调可以拒绝有关危险知识的问题,但这些保护措施通常可以被绕过。遗忘方法旨在完全消除模型中的危险功能,并使对手无法访问它们。本文从对抗性的角度讨论了遗忘和传统安全训练后之间的根本区别。本文发现,如果精巧地使用现有的越狱方法,是可以成功让模型输出被遗忘的东西的。此外,本文开发了各种自适应方法来恢复大多数被认为是遗忘的能力。

哈利波特遗忘论文阅读笔记

Published:

大型语言模型 (LLM) 在海量互联网语料库上进行训练,这些语料库通常包含受版权保护的内容。这对这些模型的开发者和用户以及原作者和出版商构成了法律和道德挑战。本文提出了一种遗忘技术,用于从 LLM 中遗忘训练数据的子集,而无需从头开始重新训练。 本文在从 Llama2-7b 模型遗忘哈利波特书籍的任务上评估了我们的技术。在大约 1 GPU 小时的微调中,本文有效地消除了模型生成或调用哈利波特相关内容的能力,而其在常见基准测试上的表现几乎不受影响。 由三个主要部分组成:首先使用一个在目标数据上进一步训练的强化模型,通过将其逻辑与基线模型的逻辑进行比较,识别与目标最相关的标记。其次用通用的对应词替换目标数据中的特殊表达,并利用模型自身的预测为每个标记生成替代标签。这些标签旨在近似未在目标数据上训练的模型的下一个标记预测。在这些替代标签上对模型进行微调,这样每当模型被提示上下文时,就会有效地从模型的内存中删除原始文本。

large language model unlearning论文阅读笔记

Published:

本文研究如何在大型语言模型 (LLM) 上进行遗忘,即忘记不良的不当行为。本文展示了至少三种将 LLM 与人类偏好对齐的场景可以从反学习中受益:(1) 删除有害反应,(2) 删除受版权保护的内容,以及 (3) 减少幻觉。遗忘作为一种对齐技术,有三个优点。(1) 它只需要负面(例如有害)示例,这些示例比 RLHF(从人类反馈中进行强化学习)所需的正面(例如有帮助且通常是人类编写的)示例更容易和更低成本地收集(例如通过红队或用户报告)。(2) 它在计算上是高效的;成本与轻度监督微调相当。(3) 当我们知道哪些训练样本导致不当行为时,它特别有效。

知识间隔对齐论文笔记

Published:

最近关于“被遗忘权”的立法引发了人们对机器反学习的兴趣,即学习到的模型被赋予忘记特定训练实例信息的功能,就好像它们从未存在于训练集中。以前的工作主要集中在计算机视觉场景中,在很大程度上忽略了 NLP 领域遗忘的本质,因为文本数据比图像包含更多明确和敏感的个人信息。本文提出了一个称为 KGA 的通用遗忘框架来诱导遗忘。与试图恢复梯度或强制模型接近某一特定分布的工作不同,KGA 保持了分布差异(即知识差距)。此外,本文首先将遗忘方法应用于各种 NLP 任务(即分类、翻译、响应生成),并提出了几个有针对性的反学习评估指标。在大规模数据集上的实验表明,KGA 比基线有了全面的改进,其中广泛的分析进一步验证了 KGA 的有效性并为 NLP 任务的反学习提供了见解。

SeUL论文阅读笔记

Published:

本文介绍了一种用于在语言模型中实现精确和选择性遗忘的新方法。与以前采用完全相反的训练目标的方法不同,这种方法旨在减轻对语言模型性能的不利影响,特别是在生成任务中。此外,还提出了两个创新的评估指标:敏感信息提取可能性 (S-EL) 和敏感信息记忆准确度 (S-MA),旨在衡量敏感信息消除的有效性。为了加强遗忘框架,提出了一种注释敏感范围的有效方法,涉及在线和离线策略。在线选择机制利用语言概率分数来确保计算效率,而离线注释则需要基于大型语言模型 (LLM) 的强大两阶段过程。

大模型机械可解释性论文笔记

Published:

了解人工智能系统的内部工作原理对于确保价值一致性和安全性至关重要。本综述探讨了机械可解释性:将神经网络学习到的计算机制和表示逆向工程为人类可理解的算法和概念,以提供细致的因果理解。本文建立了基础概念,例如神经激活中编码知识的特征以及关于其表示和计算的假设。本文调查了因果剖析模型行为的方法,并评估了机械可解释性与人工智能安全性的相关性。本文研究了理解、控制、一致性方面的好处以及能力提升和双重用途问题等风险。本文研究了可扩展性、自动化和全面解释方面的挑战。我们主张澄清概念、制定标准和扩展技术以处理复杂的模型和行为,并扩展到视觉和强化学习等领域。随着人工智能系统变得更加强大和难以捉摸,机械可解释性可以帮助防止灾难性后果。

大模型训练动态论文笔记

Published:

尽管大型语言模型被广泛采用,但人们对其潜在的训练和记忆动态还不是很了解。我们实证研究了因果语言模型和掩蔽语言模型中跨模型大小和整个训练过程的精确记忆。我们测量了数据集大小、学习率和模型大小对记忆的影响,发现较大的语言模型在所有设置中记忆训练数据的速度都更快。令人惊讶的是,我们发现较大的模型可以在过度拟合之前记住更大一部分数据,并且在整个训练过程中遗忘的更少。我们还分析了不同词性的记忆动态,发现模型首先记忆名词和数字;我们假设并提供实证证明了名词和数字是记忆单个训练示例的唯一标识符。

本文的背景

模型记住其训练数据的速率和程度提供了有关它如何可能泛化到新测试实例的证据。经典框架(偏差-方差均衡)主张在不完全记忆的情况下拟合训练集,但近期深度学习的研究建立的记忆和泛化之间更为共生的关系[^13][^26][^28]。

大模型遗忘论文阅读杂记

Published:

2022

Knowledge unlearning for mitigating privacy risks in language models阅读笔记

Published:

预训练语言模型(LMs)在初始预训练过程中会记忆大量的知识,包括可能侵犯个人生活和身份隐私的信息。以往针对LMs隐私问题的工作主要集中在数据预处理和差分隐私方法上,这两者都需要重新训练底层的LM。本文提出知识遗忘作为一种替代方法,以减少LMs事后的隐私风险。本文通过简单地对目标token序列执行梯度上升,在不降低大型LMs的一般语言建模性能的情况下忘记目标序列。本文发现顺序遗忘比一次性尝试遗忘所有数据更有效,并且遗忘高度依赖于被遗忘的数据类型(领域)。通过与已知可以减轻LMs隐私风险的先前方法进行比较,本文方法可以在已知数据容易受到提取攻击的场景中提供更强的经验隐私保证,同时更加高效和稳健。

隐私保护大模型阅读笔记

Published:

语言模型是在大量人类语言文本上为单词序列预测任务训练得到的系统,应用于任何人类使用自然语言的场景,比如呼叫中心,医疗应用,移动电话和PC和家庭助手,电子邮件和信息自动补全服务,文档翻译和检索,写作助手等等。典型的语言模型任务包括部分词性 (POS) 标记和解析、光学字符识别 (OCR)、自动语音识别、自然语言生成、情感分析和自然语言推理。基于这些任务的应用程序会大规模处理潜在的私人数据,例如用户查询、敏感文档、电子邮件和私人对话。

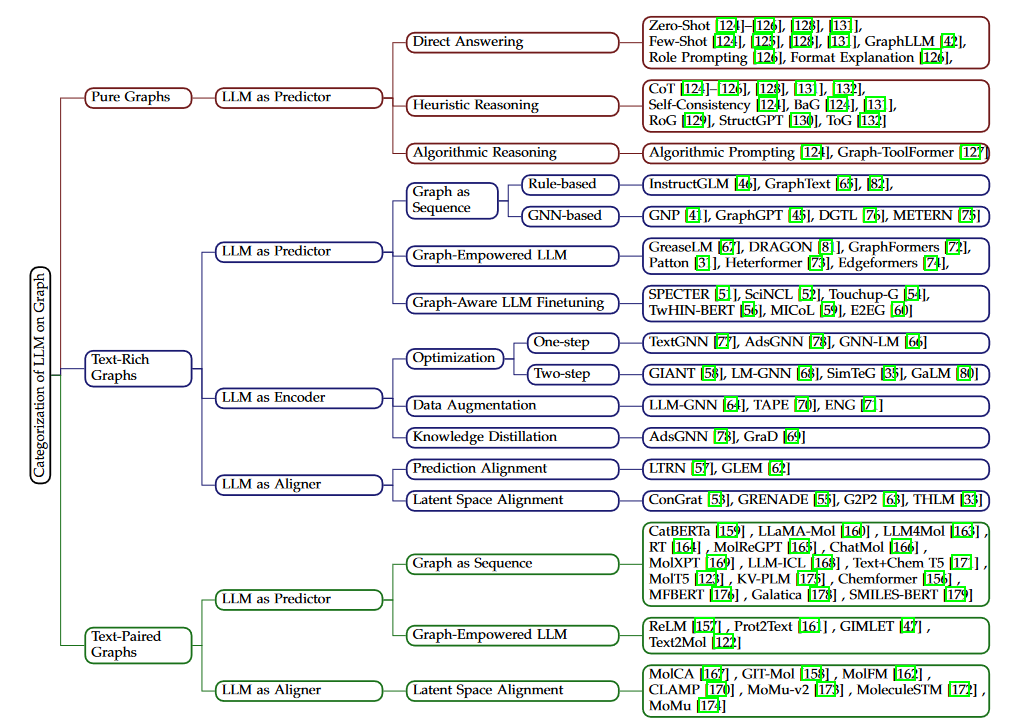

大模型与图学习的结合场景调研

Published:

主要关注大模型和GNN结合的场景,包括与大模型有关的图的场景和大模型在图学习技术上起到的角色。

与大模型有关的图的场景

完全没有文本信息的图:这种图数据没有文本信息或者没有语义丰富的文本信息,比如交通网络,能量传输网络等。这种图一般作为测试大模型的图推理能力的上下文,或者作为强化大模型的知识源(缓解幻觉)。 文本属性图:这种图的节点或者边上有语义丰富的文本信息,也被称为富文本网络,文本网络或者边文本网络,包括学术网络,线上经济网络,社交网络,法律案例网络等。这些图上的任务一般包括学习节点和边的同时具有结构和文本信息的表征。 文本伴随图:这种图一般包括一个为整个图结构定义的文本描述,比如分子网络一般伴随一个标题或者文本特征。这种图上的任务一般关注使用图结构和文本描述来理解图的整体信息。

与大模型有关的图学习技术

根据大模型的角色和解决图相关问题的最后组件,可以将与大模型有关的图学习技术分为大模型作为预测器,大模型作为编码器,和大模型作为对齐器。 大模型作为预测器(LLM as Predictor):这种类型的技术将大模型作为最后输出表征或者预测结果的组件,可以通过GNNs进行强化。根据图数据注入大模型的方式可以分为

- 图作为序列:不对大模型结构做更改,使用图token序列作为输入使大模型理解图结构。图token序列可以是图的自然语言描述或者由图编码器输出的隐层表征。

- 图增强的LLM:这种方法修改大模型基础模块的结构,使其能够在结构内部完成文本和图信息的共同编码。

- 图敏感的LLM微调:这种方法不对模型输入和结构做修改,而仅在图的监督下对大模型做微调 大模型作为编码器(LLM as Encoder):这种方法一般在文本属性图上使用。GNN是最终的结果输出组件,而大模型作为开始的文本编码器。大模型首先用于编码节点和边相关联的文本信息,输出的特征向量作为GNNs的输入嵌入进行图结构编码。GNN输出的嵌入作为最终下游任务的节点/边表征。但这种方法会遇到收敛问题,数据稀疏问题和低效问题。 大模型作为对齐器(LLM as Aligner):这种方法使用大模型作为文本编码组件,使用GNN作为图结构编码组件,然后将这两个组件对齐。大模型和GNN结合到一起作为最终的输出组件来解决下游任务。大模型和GNN之间的对齐可以分为:

- 预测对齐:轮流使用一个模型生成的伪标签来训练另一个模型

- 隐空间对齐:使用对比学习技术对齐大模型生成的文本嵌入和GNN生成的图嵌入

技术和场景的结合方式

大模型遗忘综述论文阅读思考笔记

Published:

遗忘的动机

GUAP论文阅读思考笔记

Published:

前置定义

Model Size Gpu Storage Consumption

Published:

LLM训练推理时GPU显存耗用量估计

联邦遗忘综述

Published:

联邦遗忘

联邦图神经网络综述

Published:

术语和分类

奖励对齐方法背景

Published:

背景

幻觉论文阅读杂记

Published:

幻觉原因分析

2020

DRO论文阅读笔记

Published:

一种保护LLM防御有害查询的方法是预先设置的模型输入带有人工合成的安全提示(safety prompt),通常包含对模型行为的明确指导和界限,但这种方式的工作机制没有很明确的研究,本文做了两种假设:(1) 模型不能很好地区分有害查询和无害查询,而安全提示增强了模型的有害识别能力。(2) 模型可以识别有害查询,但不能拒绝有害查询,而安全提示增加了整体拒绝(即拒绝提供帮助)的概率。然后通过可视化分析对机制进行了研究,最终提出了一种新的prompt表征优化方法。

Hallucination is inevitable论文阅读笔记

Published:

相关定义

AI explanation论文阅读杂记

Published:

USENIX Security

安全论文阅读杂记

Published:

ICLR

data stealing attack论文阅读杂记

Published:

S&P

AI对齐论文阅读杂记

Published:

2017

model stealing attack论文阅读杂记

Published:

S&P

Finding MNEMON:Reviving Memories of Node Embeddings论文阅读笔记

Published:

研究图神经网络上的数据窃取攻击问题,当前工作主要关注隐藏图上信息或者理解图神经网络的安全性和隐私问题,没有关注上游模型和下游任务pipeline整合时的隐私风险。即当上游模型提供节点表征向量时,下游可以通过这些向量反向窃取上游的图结构信息。

大模型幻觉综述

Published:

幻觉类型

APO背景知识

Published:

RLHF相关方法回顾

大模型系统安全综述

Published:

LLM系统的模块

大模型对齐综述

Published:

背景

Base of Vulnerability Analysis

Published:

漏洞分析基础按照程序编译、执行和分析划分,主要描述一下编译部分。执行是把程序装载进内存然后配合处理器逐步执行,涉及到汇编指令和内存地址,分析主要是静态分析和动态分析的指令和工具,这俩部分没啥总结的必要,用的时候查就完了

DPO背景知识

Published:

RLHF流程回顾

PPO背景知识

Published:

目测CPM的PPO策略实现与这篇论文一致,所以先看这篇论文

还会带一点Training language models to follow instructions with human feedback(以下用openAI代替)的东西,因为数据处理等实现参考了这边

Vulnerability mitigation

Published:

基础概念

Access Control

Published:

访问控制是在系统中基于访问控制规则对可执行的动作进行限制的安全机制。

Security Target and Mechanism

Published:

安全目标

Isolation

Published:

隔离思路

大模型道德价值观对齐问题剖析笔记

Published:

大模型的风险和道德问题

CPA与CCA基础知识

Published:

CPA: Chosen-plaintext attack

(NDSS23)”Machine Unlearning of Features and Labels”论文阅读笔记

Published:

论文概述

Mini Survey of Interpretable AI for Network Security

Published:

XAI for network security笔记

Mini Survey of Machine Unlearning

Published:

Machine Unlearning 相关笔记

Foundations of Coin Mixing Services

Published:

混币服务的基础

XAI survey for networking

Published:

可解释AI与计算机网络综述

Backgrounds of Coin Mixing Service

Published:

混币服务

Blog Post number 4

Published:

This is a sample blog post. Lorem ipsum I can’t remember the rest of lorem ipsum and don’t have an internet connection right now. Testing testing testing this blog post. Blog posts are cool.

Blog Post number 3

Published:

This is a sample blog post. Lorem ipsum I can’t remember the rest of lorem ipsum and don’t have an internet connection right now. Testing testing testing this blog post. Blog posts are cool.

Blog Post number 2

Published:

This is a sample blog post. Lorem ipsum I can’t remember the rest of lorem ipsum and don’t have an internet connection right now. Testing testing testing this blog post. Blog posts are cool.

Blog Post number 1

Published:

This is a sample blog post. Lorem ipsum I can’t remember the rest of lorem ipsum and don’t have an internet connection right now. Testing testing testing this blog post. Blog posts are cool.

portfolio

Portfolio item number 1

Published:

Short description of portfolio item number 1

Portfolio item number 2

Published:

Short description of portfolio item number 2

publications

Paper Title Number 3

Published in Journal 1, 2015

This paper is about the number 3. The number 4 is left for future work.

Recommended citation: Your Name, You. (2015). "Paper Title Number 3." Journal 1. 1(3).

Download Paper | Download Slides

talks

teaching

(TA) Digital Logic Circuit

Undergraduate course, Tsinghua University, Department of Computer Science, 2024

I worked as a teaching assistant for the undergraduate course Digital Logic Circuit in the Spring Term of 2023-2024. My primary responsibilities include grading assignments and answering questions.